- Home

-

Hochschule

- Aktuelles

-

Profil

- Zahlen, Daten, Fakten

- Selbstverständnis der HSBI

- Qualitätsverständnis

- Leitbild Lehre

- Lehrpreis

- Netzwerk Innovatives Lehren und Lernen (InnoLL)

- Prozessmanagement

- Familiengerechte Hochschule

- Diversity

- Weltoffene Hochschule

- Strategie Internationales

- Nachhaltigkeit

- Rückblick: 50 Jahre FH Bielefeld

- Feedback

- Fachbereiche

- Zentrale Organisation

- Standorte / Anfahrt

- HSBI-Portale

-

Studium

- Studienangebote

-

Beratung

- Studienorientierung

- Zentrale Studienberatung

- Studienfachberatung

- Psychosoziale Beratung

- Studienfinanzierung und Stipendien

- Schreibberatung

- Studieren mit beruflicher Qualifikation

- Studieren mit ausländischen Zeugnissen

- Studieren mit Handicap

- Studieren mit Familie

- Informationen für Schulen

- Auslandsaufenthalt

-

Bewerbung

- Auswahlgrenzen und Vergabeverfahren (NC)

- Bewerbungsportal

- Bewerbung Schritt für Schritt: Von der Bewerbung bis zur Einschreibung

- Bewerbung für ein höheres Fachsemester

- Bewerbung mit beruflicher Qualifikation

- Gasthörerschaft und Zweithörerschaft

- Kontakt Studierendenservice

- Losverfahren

- Promotion

- Sonderanträge

- Studiengang wählen

- Wer kann an der HSBI studieren?

- Studienstart

-

Studium organisieren

- Studierendenservice

- Abschlussunterlagen

- Anerkennung von Leistungen

- Anträge einreichen

- Beurlaubung

- CampusCard

- Einreichung schriftliche Arbeiten

- Erstattung

- Exmatrikulation

- IT-Services

- Online-Serviceportale (LSF/CAT)

- Prüfungsangelegenheiten: Ordnungen, Modulhandbücher

- Rücktritt von einer Modulprüfung

- Rückmeldung

- Semesterbeitrag

- Semesterticket (Studi-Deutschlandticket)

- Semester-, Vorlesungs- und Prüfungszeiten

- Studienbezogene Auslandserfahrung

- Studiengebühren

- Vorlesungsverzeichnis

- Rund ums Studium

- Fachbereiche

- Forschung

- Transfer

- Weiterbildung

- Internationales

- Karriere an der HSBI

Anwendung von KI-basierten Methoden in der Arbeitswelt zur Belastungsreduktion von Mitarbeiter*innen in der Produktion

Projektübersicht

| Anzahl Studierende | 1-2 |

| Art | gefördertes Projekt mit externem Partner |

| Projektverantwortung | Prof. Dr.-Ing. Martin Kohlhase |

| Projektkontext |

Projekt in Zusammenarbeit mit der Firma Bette GmbH & Co. KG aus Delbrück und dem Center for AppliedData Science Gütersloh (CfADS). Eine parallele Anstellung als WHK am CfADS ist möglich. |

| Projektdurchführung |

Leon Vogel |

Wie wird Künstliche Intelligenz (KI) die Arbeitswelt verändern? Wie können Unternehmen neue Technologien einsetzen, um ihre Beschäftigten zu entlasten und ihre Wettbewerbsfähigkeit zu steigern? Und wie könnenBeschäftigte auf den Wandel vorbereitet werden? Antworten auf diese Fragen liefert das Kompetenzzentrum „KI fürdie Arbeitswelt des industriellen Mittelstands“ (KIAM), indem das Center for Applied Data Science Gütersloh (CfADS) aktiv mitarbeitet.

Sicher ist, Künstliche Intelligenz wird die Arbeitswelt grundlegend verändern und dieses Vorhaben im Forschungsmaster soll dazu beitragen.

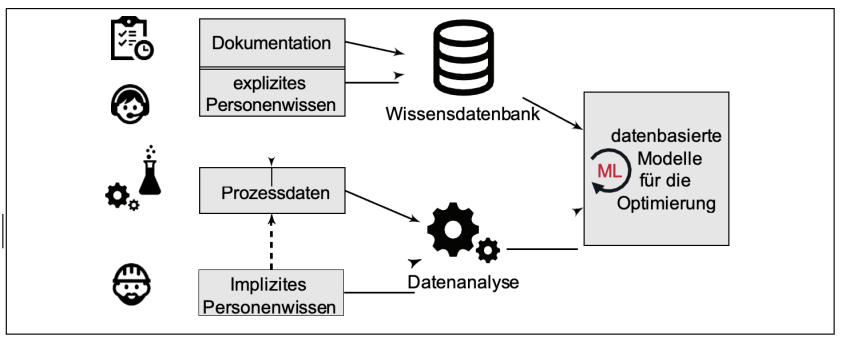

Das CfADS forscht gemeinsam mit der Firma Bette in einem Leuchtturmprojekt zum Thema „Gestaltung derArbeitswelt mittelständischer Unternehmen mit KI-basierten Wissensmanagement- undEntscheidungsunterstützungssystemen“. Eine Fragestellung in diesem Kontext ist, wie können Belastungen der Belegschaft in der Produktion reduziert werden, indem in der Arbeitsvorbereitung und -planung die richtigen Entscheidungen (Maßnahmen) getroffen werden? Bei den produzierenden Praxispartnern, wie bspw. der FirmaBette, kommt es in der Produktion immer wieder zu Entscheidungen in der Verteilung der Arbeitsaufträge, die zu erhöhten und unausgeglichenen körperlichen Belastungen für die Mitarbeiter*innen führen. Bspw. kann es dazu kommen, dass aufgrund eines Arbeitsplans ein häufiger manueller Werkzeugwechsel am Arbeitsplatz stattfinden muss, was zu einer Belastung der Belegschaft führt. Eine verbesserte Verteilung oder Reihenfolge der zuproduzierenden Güter kann zu einer deutlichen Reduktion der Belastungen führen und fördert zugleich sowohl die Arbeitssituation der Mitarbeiter*innen als auch die Effizienz des gesamten Prozesses. Dieses Ziel soll mit Hilfe von KI, insbesondere maschineller Lernverfahren, erreicht werden.

Der / Die Studierende soll im Rahmen des Forschungsprojekts maschinelle Lernverfahren (ML) auswählen, ggf. modifizieren und anwenden, die eine Optimierung des Produktionsablaufes, auch unter dem Gesichtspunkt der Belastungsreduktion von Werkerinnen und Werker, ermöglichen. Dafür steht eine ausgiebige Datengrundlage derFirma Bette zur Verfügung, die zu Beginn untersucht und maschinell aufbereitet werden soll. Durch ML-Verfahren sollen die aktuellen Prozesse und Arbeitsschritte in der Produktion bewertet werden. In diesem Zusammenhang sollen geeignete ML-Verfahren ausgewählt und verglichen werden. Zu Beginn soll auf etablierte Toolboxen zurückgegriffen werden, wobei im fortgeschrittenen Projektverlauf ein ausgewähltes Verfahren eigenständig programmiert und angepasst werden soll. Je nach Projektfortschritt kann das Ziel verfolgt werden, mittels der ML-Verfahren die Produktionsabläufe zu verbessern, sodass eine Reduktion der Belastungen in der Belegschaft messbar wird. In der Produktion wird eine Vielzahl von Daten und Signalen erfasst. Diese Daten müssen gewinnbringend genutzt werden, um zum einen das Unternehmen wettbewerbs- und zukunftsfähig zu machen und zum anderen dieMitarbeiter*innen und die globalen Ressourcen zu schonen. Diese Daten liegen in den meisten Fällen unstrukturiert vor und im schlechtesten Fall auf verschiedenen Datenträgern (Datenbanken). Diese Daten müssen zu Beginnzusammengeführt und untersucht werden. Dazu sollen von Anfang an ML-Verfahren eingesetzt werden. Die Untersuchungen sollen die Qualität und den Informationsgehalt der Daten aufzeigen und bestätigen. Andernfalls müssen weitere Daten gezielt in der Produktion erhoben werden. Zudem sollen die Daten mittels ML aufbereitetwerden, sodass eine Weiterverarbeitung möglich wird.

Aus den erfassten Daten sollen Muster und Kenngrößen zur Bewertung der aktuellen Produktionsabläufe extrahiert werden. Dafür sollen ML-Verfahren gezielt ausgewählt (bspw. 3 ML-Verfahren für einen Benchmark) und verglichen werden. Aus den gewonnenen Erkenntnissen sollen zum einen Strategien und weitere Lernverfahren zur Verbesserung des Produktionsablaufs bei gleichzeitiger Reduktion der Belastungen der Belegschaft abgeleitet werden. Zum anderen ist es in vielen Fällen notwendig, bereits etablierte ML-Methoden hinsichtlich der eigens formulierten Zielsetzung zu modifizieren und zu verbessern. In diesem Vorhaben soll ein ausgewähltes Verfahren eigenständig implementiert und zur Lösung der vorliegenden Problemstellung angepasst werden.

Neben den Prozessen beim Projektpartner Bette können zu Beginn auch Testprozesse in der IoT-Factory des CfADS untersucht werden. Der Vorteil liegt darin, dass nicht zu Beginn der Umsetzungsphase an kritischen Produktivsystemen gearbeitet werden muss. Zudem können die ML-Verfahren auf dem CFADS-eigenen Data-Analytics-Cluster implementiert und effizient untersucht werden.

Bezug zum Thema Data Science

Im Rahmen der Tätigkeit soll der Studierende in Zusammenarbeit mit den Mitarbeitern des CfADS bei der Realisierung eines Data Science Workflow mitwirken. Es werden Prozessdaten aus realen Anwendungen erhobenund mittels Data-Mining-Verfahren bzw. ML-Verfahren verdichtet und für die Erstellung von datenbasierten Ansätzen herangezogen. Die Daten sollen unter der Verwendung der Cloud- Plattform des Center for Applied Data Science verarbeitet werden. Diese basiert auf dem Haadoop-Framework, welches für Big-Data-Analysen ausgelegt ist. Folglich können die in den Veranstaltungen des Forschungsmasters erworbenen Erkenntnisse direkt im Projekt angewendet werden.

Verfügbare Ressourcen

Für die Bearbeitung des Projekts kann die Infrastruktur des CfADS genutzt werden, die aus folgenden Komponenten besteht:

- Data-Analytics-Cluster: rechenstarker Computercluster auf Basis des Hadoop-Frameworks

- IoT-Factory: Modellfabrik zur Nachbildung realer Produktionsabläufe

- Smart Service Lab: Labor zur Entwicklung von Smart Services und Assistenzsystemen auf Basis von Smart Devices.

Die notwendige Datengrundlage wird durch die Firma Bette gestellt oder kann zu Beginn durch die Nutzung der IoT-Factory geschaffen werden.

Projektplan

Erstes Semester:

Konkretisierung des Forschungsvorhabens. Dies beinhaltet die Einarbeitung in die CfADS-Infrastruktur, in die Daten und in die zu betrachtenden Prozesse. Ebenso wird mit einer Literaturrecherche und der Einarbeitung in die Thematikbegonnen. Die Erstellung eines Forschungsexposés am Ende des Semesters ist Prüfungsleistung.

Zweites Semester:

Tiefere Einarbeitung in ausgewählte Verfahren und eine erste Implementierung der Verfahren. Die Untersuchung erfolgt zunächst anhand von Testprozessen (IoT-Factory) oder ausgewählten Daten aus der Produktion von Bette. Die Erstellung eines Papers zum Stand der Forschung (Überblick über das jeweilige Forschungsgebiet) ist Prüfungsleistung.

Drittes Semester:

Anwendung ausgewählter Verfahren auf reale Prozessdaten der Firma Bette. Die Erstellung eines Papers mit ersten quantitativen Ergebnissen ist Prüfungsleistung.

Viertes Semester:

Anwendung und Optimierung der Produktionsschritte bei Bette mit dem ausgewählten Verfahren. Dies beinhaltet dieAuswertung der Güte und die Evaluierung der erzielten Ergebnisse. Die Masterarbeit inklusive Kolloquium ist Prüfungsleistung.

Eignungskriterien

Zwingend:

- Grundkenntnisse der Informatik

- Erfahrungen im Umgang mit Tools zur Auswertung großer Datenmengen, wie z.B. MAT- LAB/Simulink, Python

- Teamfähigkeit und Interesse an wissenschaftlicher Arbeit

Optional:

- Erfahrungen in den Bereichen der Regelungs- und Automatisierungstechnik, Statistik (Data- Science) und der Visualisierung von Daten und deren Zusammenhänge

Erwerbbare Kompetenzen

- Praktischer Einsatz verschiedener Verfahren des maschinellen Lernens

- Big-Data Workflows unter der Verwendung eines Hadoop-Ökosystems

- Maschinelle Lernverfahren, speziell im Bereich der heterogenen Datenanalyse

- Aufbereitung und Präsentation von Analyseergebnissen